Z Katarzyną Szymielewicz rozmawiamy o tym, jak nas mielą platformy internetowe i co zrobić, by nie stać się cyfrową biomasą.

(Wywiad jest zredagowaną i uzupełnioną wersją podcastu Czy masz świadomość? pt. Czy jesteś cyfrową biomasą? Google, telefon i Twoje życie z 30 stycznia 2024 roku).

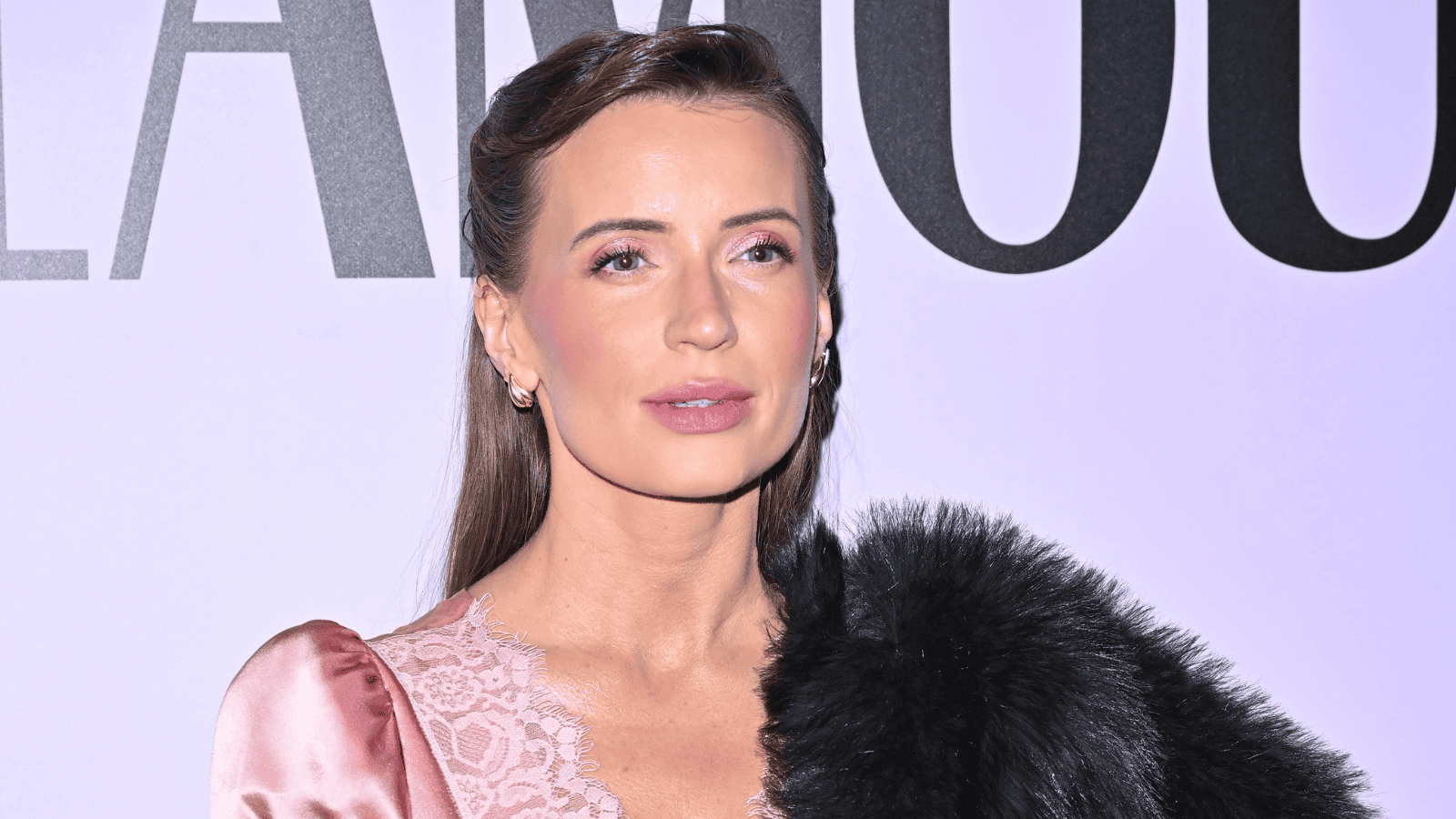

Katarzyna Szymielewicz

Prawniczka specjalizująca się problematyce praw człowieka i nowych technologii, działaczka społeczna i publicystka. Współzałożycielka i szefowa Fundacji Panoptykon, w latach 2012‑2020 wiceprzewodnicząca europejskiej sieci European Digital Rights. Absolwentka Wydziału Prawa i Administracji UW oraz Development Studies w School of Oriental and African Studies. W przeszłości – prawniczka w międzynarodowej kancelarii Clifford Chance, członkini rad społecznych przy Ministrze ds. Cyfryzacji. Członkini Ashoki – międzynarodowej sieci zrzeszającej przedsiębiorców społecznych. Publikowała m.in. w The Guardian, Polityce, Gazecie Wyborczej, Dzienniku Gazecie Prawnej i magazynie Pismo.

Rafał Górski: Co to znaczy, iż jesteśmy mieleni na cyfrową biomasę?

Katarzyna Szymielewicz: To brutalne określenie, którego używam, żeby wybić konsumentów usług internetowych z poczucia komfortu – w mojej ocenie fałszywego, ponieważ nie mamy tam podmiotowości i nie kontrolujemy procesu, w który wciągają nas dostawcy usług internetowych. Celem tego procesu jest wyzyskanie i skomercjalizowanie naszej uwagi, a przy okazji zdobycie wiedzy, która pozwoli robić to jeszcze skuteczniej.

Platformy internetowe od początku nie traktowały nas jak klientów. Nigdy nie mogliśmy sterować logiką ich algorytmów ani kontrolować tego, co projektanci usług cyfrowych nazywają „doświadczeniem użytkownika”.

Platformy takie jak Google czy Facebook zwabiły nas obietnicą darmowej i dodatkowo spersonalizowanej usługi – „skrojonej na miarę”, jak mówił Mark Zuckerberg. W realnym świecie, kiedy zamawiamy coś, co jest krojone na miarę, na przykład buty, to płacimy więcej, nie mniej. A w tym przypadku dostaję spersonalizowaną usługę i nie płacę! W praktyce oczywiście płacę, i to być może więcej niż kiedykolwiek za jakąkolwiek usługę. To jest myśl, którą poddaje pod rozwagę Tristan Harris, były pracownik Google, założyciel jednej z najbardziej krytycznych wobec big-techów instytucji – Centre for Humane Technology. On właśnie powiedział przewrotnie, iż nie było w historii ludzkości droższej dla nas usługi niż ta darmowa. Jako społeczeństwo płacimy za nią zdrowiem psychicznym, uzależnieniami, pieniędzmi wydanymi na nikomu niepotrzebne produkty czy błędnymi wyborami politycznymi.

Zdaniem Harrisa szkody wyrządzane nam przez model biznesowy platform internetowych można opisać jedną frazą: downgrading humanity, czyli degradowanie nas jako ludzkości. Dzieje się tak, ponieważ algorytmy żerują na naszych bazowych, pierwotnych potrzebach i podstawowych instynktach. Wzmacniają w nas próżność, egoizm i skłonność do obwiniania innych za nasze problemy. Wspierają naszą skłonność do polaryzacji, uciekania w bańki informacyjne i szukania ukojenia w teoriach spiskowych. Nakręcają hejt i personalne nagonki w internecie.

To wszystko jest skutkiem ubocznym modelu biznesowego wielkich platform, ale zupełnie nieprzypadkowym – te społeczne efekty są wpisane w działania systemów rekomendacyjnych, które mają jedno zadanie: zaangażować nas za wszelką cenę. Po to, żeby zysk z reklamy utrzymał się na wysokim poziomie, bo tylko zaangażowany, obecny użytkownik może zobaczyć i zareagować na reklamę. Zdaniem Harrisa obserwujemy swoisty „wyścig do dna” pomiędzy tego typu platformami, bo kto lepiej rozpracuje i wykorzysta nasze podstawowe instynkty, ten okaże się najbardziej skuteczny w angażowaniu, a tym samym osiągnie największe zyski z reklam.

To nie ludzie decydują o tym, co będzie im pokazywane w sieci i czego będą doświadczać, tylko firma dzięki jej uczących się algorytmów.

Z jednej strony przetwarzają one nasze ślady cyfrowe na profile marketingowe, czyli próbują rozpracować wzorzec zachowania, cechy, potrzeby, do których potem można dopasować serwowane treści. Z drugiej strony, inne zestawy algorytmów zajmują się dobieraniem treści do doświadczenia w taki sposób, żebyśmy jako konsumenci, jako osoby poddane przetwarzaniu na biomasę cyfrową, utrzymali swoją uwagę i klikali jak najdłużej choćby wtedy, gdy poczujemy się zmęczeni, nasyceni, wkurzeni lub wystarczająco już zainspirowani tymi treściami.

Kluczem do trafnego przewidywania, w co klikniemy (co nas skutecznie zaangażuje), są dane wyinterpretowane z naszego zachowania. Przy czym najcenniejsze, z punktu widzenia platformy, nie są informacje, które świadomie przekazujemy, ale metadane i obserwacje behawioralne, których zupełnie nie kontrolujemy: lokalizacja telefonu, numery IP, z jakich się logujemy, linki, w które klikamy, posty, które wywołują nasze reakcje, osoby, z którymi wchodzimy w interakcje, jak również to, kiedy korzystamy z aplikacji, w jakiej pozycji trzymamy wówczas telefon, jak gwałtownie piszemy, a choćby w jaki sposób ładujemy urządzenie.

Ten brutalny mechanizm zoptymalizowany jest na komercyjny zysk, a nie na wartość dla człowieka, nazywanego „użytkownikiem”, czyli kimś zależnym, poddanym obróbce, a nie klientem, który sam decyduje. Termin „cyfrowa biomasa” powstał w celu unaocznienia mechanizmu mielenia nas.

Co obywatel może zrobić, żeby nie być cyfrową biomasą?

Na to pytanie nie ma prostej odpowiedzi. Na pewno nie jest nią kontynuowanie korzystania z obecnego modelu, tak jakby był on dla nas neutralny, bo nie jest i powinniśmy go zmienić.

Firmy podsuwają nam ustawienia prywatności, ustawienia reklam. Możemy spędzić dużo czasu z „suwakami”, które są dostępne na platformach internetowych i próbować je dopasować. Nie jest to działanie pozbawione sensu, ponieważ do pewnego stopnia możemy ulepszyć nasze doświadczenie i ochronić się przed najbardziej toksycznymi czy agresywnymi formami tego, co na nas czeka w sieci. Możemy skalibrować filtr, przez który trafiają do nas takie, a nie inne informacje, możemy wyłączyć powiadomienia, do czego wszystkich zachęcam, możemy ustawić wyłączniki czasowe, żeby się samoograniczyć; możemy też usunąć zbędne aplikacje z telefonu lub korzystać z nich tylko wtedy, kiedy jest to konieczne.

Ustawienia prywatności dają nam złudzenie kontroli. W rzeczywistości wszystkie ścieżki UX prowadzą do miejsca, w którym jesteśmy śledzeni, a nasze dane z różnych źródeł są łączone w profile behawioralne. Powiadomienia, interfejs, algorytmy rekomendujące treści, a choćby samo urządzenie, z którego korzystamy (żywe kolory w telefonie) – wszystko zaprojektowane jest tak, żeby wpływać na wydzielanie dopaminy i w dłuższym horyzoncie uzależniać. Dzięki mechanizmowi nieregularnych wzmocnień, znanemu z gier hazardowych, statystycznie sprawdzamy powiadomienia z aplikacji choćby 150 razy dziennie.

Platformy zatrudniają najlepszych naukowców i wydają miliardy dolarów po to, by jak najlepiej poznać i wykorzystać ewolucyjne uwarunkowania naszego mózgu. Dlatego to nie jest równa walka.

Na pewno nie jest tak, iż jako obywatele nie możemy zrobić nic, ale są to zmiany w ramach paradygmatu, w którym mamy narzuconą asymetrię władzy – to nie my jesteśmy klientem, nie my płacimy za usługę i nie my decydujemy, jakie doświadczenie będzie nam serwowane, tylko reklamodawca. Możemy zacząć od zmiany modelu biznesowego, czyli tego, w jaki sposób generowany jest zysk. Możemy próbować jako konsumenci wejść w model amerykański, w którym ktoś trzeci – zaufany partner – negocjuje w naszym imieniu, co będzie działo się z naszymi danymi albo dostarcza swój algorytm, który koryguje ten działający na nas toksycznie i wciągający nas w spiralę konsumpcji treści. Takie nakładki na platformy internetowe są technologicznie możliwe, ale jest to wchodzenie w coraz bardziej wyrafinowane usługi i płacenie za nie realnymi pieniędzmi.

1 rok temu

1 rok temu